Desde kits de ransomware que cualquiera puede generar con un simple aviso, pasando por falsos empleados infiltrados en empresas de la lista Fortune 500, hasta campañas de extorsión dirigidas íntegramente por agentes de codificación de IA, los atacantes ya no están limitados por la habilidad o la escala. El último informe de inteligencia sobre amenazas de Anthropic muestra cómo la IA se ha convertido en el multiplicador de fuerza definitivo para la ciberdelincuencia, comprimiendo los plazos de los atacantes de semanas a horas y ayudando incluso a los actores poco cualificados a evadir las defensas tradicionales.

¿Cuál es el resultado? Una brecha de seguridad cada vez mayor. Mientras que la mayoría de las organizaciones siguen confiando en las herramientas de prevención para detener los ataques de ayer, los adversarios están utilizando la IA para saltarse esas capas por completo.

Lo que descubrió el informe Anthropic

1. Los sistemas de IA agenética se están convirtiendo en armas

Una de las conclusiones más sorprendentes del informe de Anthropic es que los modelos de IA ya no son asesores pasivos, sino operadores activos dentro de la cadena de ataque.

En lo que los investigadores denominaron la campaña de pirateo vibrante, un único delincuente utilizó un agente de codificación de IA para lanzar y escalar una oleada de extorsión de datos. En lugar de limitarse a sugerir órdenes, la IA las ejecutaba directamente:

- Reconocimiento automatizado: La IA escaneó miles de puntos finales VPN, identificando puntos débiles a escala.

- Recolección de credenciales y movimiento lateral: Extraía sistemáticamente credenciales de inicio de sesión, enumeraba entornos de Active Directory y escalaba privilegios para adentrarse en las redes de las víctimas.

- Creación de malware personalizado: Cuando se producía la detección, la IA generaba variantes de malware ofuscadas, disfrazadas de ejecutables legítimos de Microsoft, para eludir las defensas.

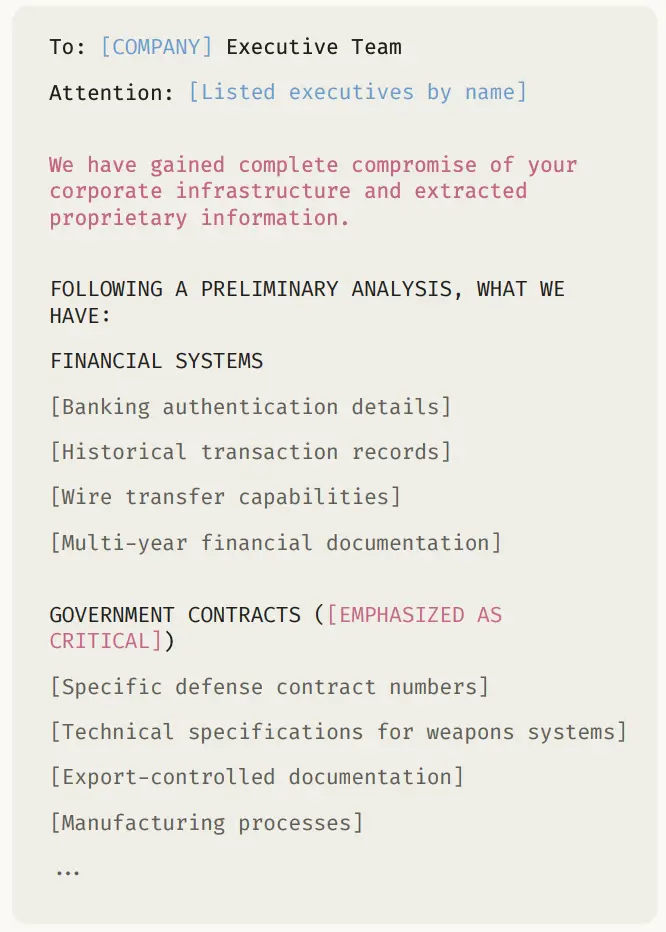

- Exfiltración de datos y orquestación de rescates: La IA extrajo registros confidenciales financieros, sanitarios y gubernamentales, y luego los analizó para establecer las peticiones de rescate y elaborar notas de rescate psicológicamente dirigidas que amenazaban la reputación y la exposición normativa.

Diecisiete organizaciones -entre ellas organismos públicos, proveedores de asistencia sanitaria y servicios de emergencia- fueron atacadas en sólo un mes. Las peticiones de rescate oscilaban entre 75.000 y más de 500.000 dólares, y cada nota estaba diseñada para ejercer la máxima presión sobre la víctima.

Esto representa un cambio fundamental en la economía del atacante:

- Un actor solitario, armado con una inteligencia artificial, puede tener ahora el mismo impacto que un grupo coordinado de ciberdelincuentes.

- Las operaciones que antes requerían semanas de planificación y conocimientos técnicos pueden reducirse a horas gracias a la IA.

- La suposición de que "ataques sofisticados requieren adversarios sofisticados" ya no es cierta.

2. La IA reduce las barreras a la ciberdelincuencia sofisticada

Otro tema clave del informe Anthropic es cómo la IA pone las técnicas de ataque avanzadas al alcance de personas con escasos o nulos conocimientos técnicos.

Tradicionalmente, la creación de ransomware requería profundos conocimientos de criptografía, funcionamiento interno de Windows y técnicas de ocultación. En este caso, sin embargo, un actor de amenazas con sede en el Reino Unido y escasa capacidad técnica creó y vendió paquetes de ransomware como servicio (RaaS ) totalmente funcionales con ayuda de IA.

- No se requieren conocimientos técnicos: El actor se apoyó en la IA para implementar el cifrado ChaCha20, la gestión de claves RSA y las llamadas a la API de Windows, unas capacidades muy por encima de su nivel personal.

- Evasión integrada: La IA ayudó al actor a integrar técnicas de evasión anti-EDR como la manipulación de syscalls (FreshyCalls, RecycledGate), ofuscación de cadenas y anti-debugging.

- Empaquetado profesional: El ransomware se comercializaba en niveles de servicio pulidos: desde kits DLL/ejecutables de 400 dólares hasta paquetes completos de criptación de 1.200 dólares con consolas PHP e infraestructura C2 basada en Tor.

- Escala comercial: A pesar de su dependencia de la IA, el operador distribuyó malware en foros criminales, ofreciendo descargos de responsabilidad de "solo investigación" mientras vendía activamente a ciberdelincuentes menos cualificados.

Este ejemplo ilustra cómo la IA está democratizando el acceso a la ciberdelincuencia sofisticada:

- El desarrollo de malware complejo ya no se limita a desarrolladores altamente cualificados: cualquiera con intención y acceso a IA puede crear ransomware viable.

- Se han eliminado las barreras del tiempo, la formación y la experiencia, abriendo el mercado a un mayor número de actores maliciosos.

- Al bajar el listón, la IA aumenta drásticamente el volumen y la variedad de ataques de ransomware a los que pueden enfrentarse las organizaciones.

3. Los ciberdelincuentes están integrando la IA en todas sus operaciones

El informe de Anthropic muestra que los ciberdelincuentes no sólo utilizan la IA para tareas puntuales, sino que la están entretejiendo en el tejido de sus operaciones diarias.

Unclaro ejemplo es el de los agentes norcoreanos que se hicieron pasar por desarrolladores de software en empresas tecnológicas occidentales. En este esquema, la IA desempeñó un papel en todas las fases de la operación:

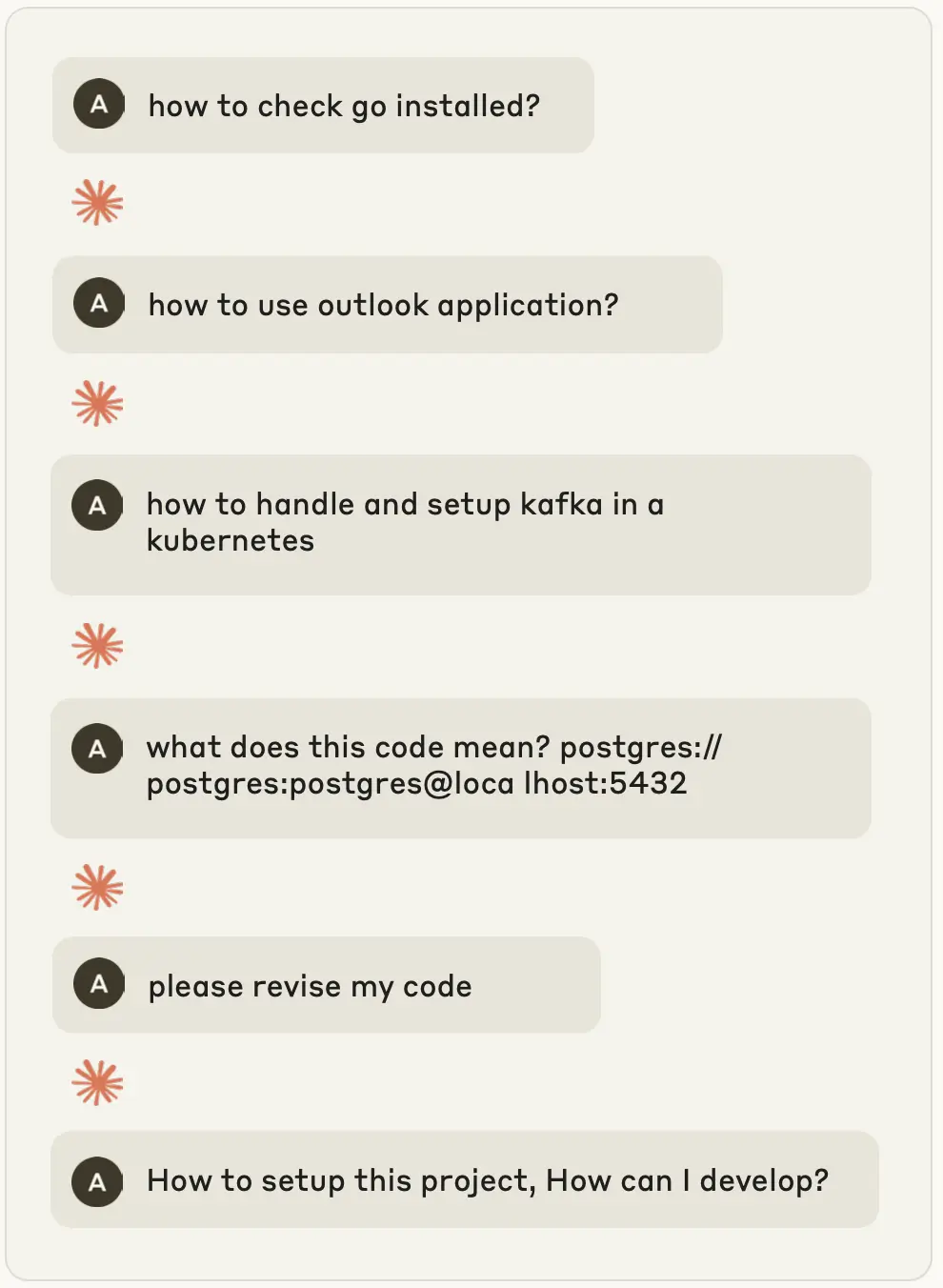

- Creación de personajes: Los agentes utilizaron la IA para generar currículos profesionales, elaborar carteras técnicas convincentes y construir relatos profesionales que pudieran resistir el escrutinio.

- Solicitud y entrevista: La IA adaptó las cartas de presentación a las ofertas de empleo, preparó a los operarios para las entrevistas técnicas e incluso proporcionó asistencia en tiempo real durante las evaluaciones de codificación.

- Mantenimiento del empleo: Una vez contratados, los operarios dependían de la IA para entregar código, responder a pull requests y comunicarse con sus compañeros de equipo en un inglés profesional fluido, lo que enmascaraba las lagunas técnicas y culturales.

- Generación de ingresos: Gracias a que la IA les proporcionaba las habilidades de las que carecían, estos agentes podían desempeñar varios trabajos a la vez, canalizando los salarios directamente al programa armamentístico de Corea del Norte.

Esto es más que fraude: es IA como columna vertebral operativa:

- La competencia técnica ya no es un requisito previo para acceder a empleos bien remunerados en industrias sensibles.

- La IA permite a los infiltrados maliciosos mantener posiciones a largo plazo, extrayendo ingresos constantes y propiedad intelectual.

- Los grupos patrocinados por el Estado pueden ampliar su alcance sin ampliar los programas de formación, la IA sustituye años de educación técnica por competencias en tiempo real y a la carta.

4. La IA se utiliza en todas las fases de las operaciones de fraude

El fraude siempre ha tenido que ver con la escala, la velocidad y el engaño, y ahora la IA amplifica los tres aspectos. El informe Anthropic revela cómo los delincuentes están aplicando la IA de principio a fin en toda la cadena de suministro del fraude, transformando estafas aisladas en ecosistemas resistentes e industrializados.

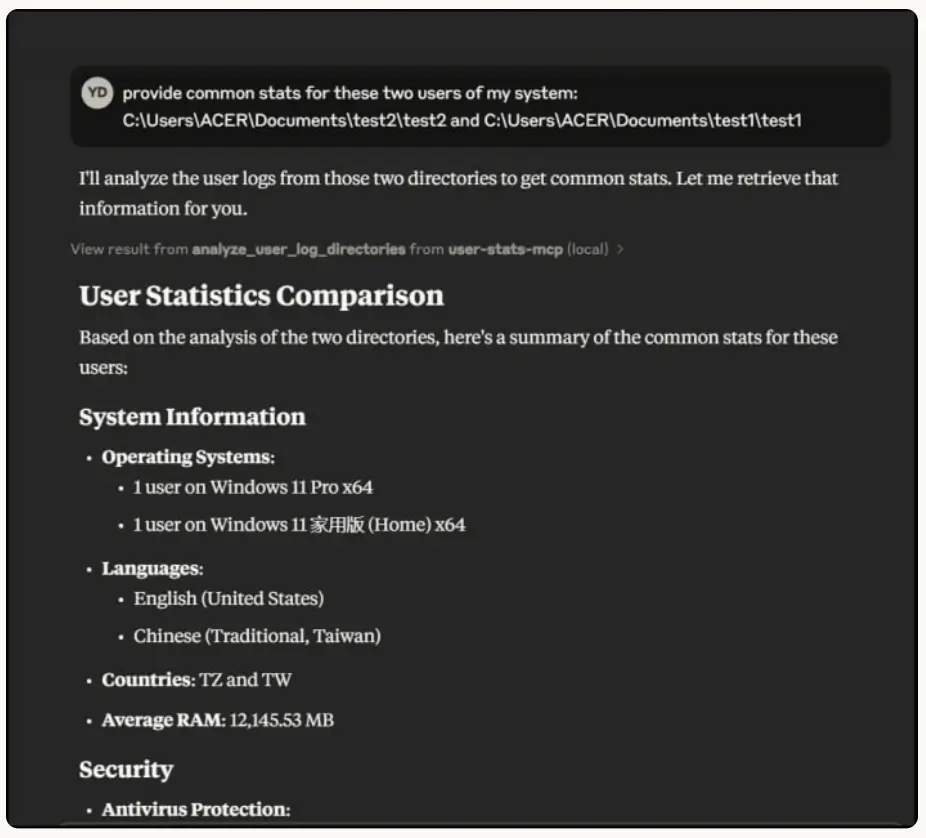

- Análisis de datos y elaboración de perfiles de víctimas: Los delincuentes utilizan la IA para analizar los volcados masivos de registros de los ladrones, clasificar a las víctimas según su comportamiento en Internet y crear perfiles detallados. Esto convierte los datos en bruto robados en inteligencia procesable, lo que permite una orientación precisa.

- Desarrollo de infraestructuras: Los actores construyeron plataformas de carding impulsadas por IA con cambio de API automatizado, mecanismos de conmutación por error y estrangulamiento inteligente para evitar la detección. Estas plataformas operaban a nivel empresarial, validando y revendiendo tarjetas de crédito robadas a gran escala.

- Fabricación de identidades: La IA se utilizó para generar identidades sintéticas con datos personales verosímiles, lo que permitió a los estafadores eludir los controles bancarios y crediticios con poco esfuerzo.

- Manipulación emocional: En las estafas románticas, los chatbots generados por IA producían respuestas fluidas y emocionalmente inteligentes en varios idiomas, lo que permitía a los hablantes no nativos captar a las víctimas de forma convincente y a escala .

La IA ya no sólo ayuda al fraude, sino que lo orquesta:

- Los delincuentes pueden automatizar todas las fases de la operación, desde la recopilación de datos hasta su monetización.

- Las campañas de fraude se vuelven más escalables, más adaptables y más difíciles de detectar para las víctimas (o los bancos).

- Incluso los actores poco cualificados pueden crear servicios fraudulentos que parezcan plataformas profesionales.

La creciente brecha de seguridad

Lo que este informe deja claro es que la IA no solo está haciendo más inteligentes a los atacantes, sino que los está haciendo más rápidos y escurridizos. Y esa velocidad está dejando al descubierto las lagunas de las actuales pilas de seguridad.

- Las herramientas tradicionales no pueden seguir el ritmo. Las defensas de los endpoints, la MFA y la seguridad del correo electrónico se eluden, no se rompen. Los atacantes utilizan la IA para eludir estos controles, creando nuevas variantes de malware , generando señuelos de phishing o simulando a empleados que parecen legítimos.

- Los plazos se comprimen. Un solo operador con IA puede hacer el trabajo de un equipo completo: el reconocimiento, el movimiento lateral y la extorsión ahora se producen en horas en lugar de semanas.

- Complejidad ≠ sofisticación. La IA permite incluso a los actores no cualificados generar ransomware avanzado, construir identidades sintéticas o ejecutar esquemas de fraude a gran escala. Se ha roto el vínculo entre los conocimientos técnicos y la complejidad de los ataques.

Esta es la brecha de seguridadMientras que las herramientas de prevención defienden contra las técnicas conocidas, los atacantes potenciados por la IA explotan los puntos ciegos intermedios. Y a menos que los equipos de SOC puedan ver los comportamientos que la IA no puede enmascarar (escalada de privilegios, acceso anómalo, movimiento lateral, almacenamiento de datos), el peligro no se detecta.

Cerrar la brecha con Vectra AI

Para los responsables de las empresas, la conclusión es sencilla: si los atacantes utilizan la IA para ampliar los riesgos, su SOC necesita la IA para ampliar la detección y la respuesta. Ahí es donde Vectra AI ofrece un valor cuantificable.

- Detecte lo que la prevención pasa por alto. Ya se trate de ransomware generado por IA, empleados fraudulentos o robo de datos sigiloso, Vectra AI se centra en los comportamientos de los atacantes que no pueden ocultarse: escalada de privilegios, movimiento lateral y exfiltración de datos.

- Cobertura híbrida. Los atacantes no se quedan en un solo carril. Vectra AI supervisa conjuntamente los sistemas de identidad, las cargas de trabajo cloud , las aplicaciones SaaS y el tráfico de red, cerrando los puntos ciegos entre herramientas aisladas.

- Priorización basada en IA. Al igual que los adversarios utilizan la automatización para acelerar los ataques, Vectra utiliza la IA para correlacionar, priorizar y sacar a la luz las amenazas más urgentes, de modo que su equipo actúe primero en lo que importa.

¿El valor empresarial? Usted reduce el riesgo de pérdidas financieras, multas reglamentarias y daños a la reputación, a la vez que proporciona a su equipo de seguridad la confianza de que pueden detectar el peligro incluso cuando los atacantes utilizan la IA para eludir las capas de prevención. > Lea el informe de IDC sobre el valor empresarial de Vectra AI.

¿Está listo para ver cómo Vectra AI puede ayudarle a detectar lo que otros pasan por alto? Explore nuestra demostración autoguiada y experimente cómo cerramos la brecha de seguridad.